Pourquoi est-ce important: Selon la personne à qui vous demandez, le marché des semi-conducteurs IA est estimé entre quelques milliards de dollars et l’infini. Nous sommes fermement dans le domaine des attentes élevées en ce qui concerne la catégorie, et la détermination d’estimations plus précises de la taille du marché est cruciale pour le grand groupe de personnes qui prendront des décisions d’investissement au cours de l’année à venir.

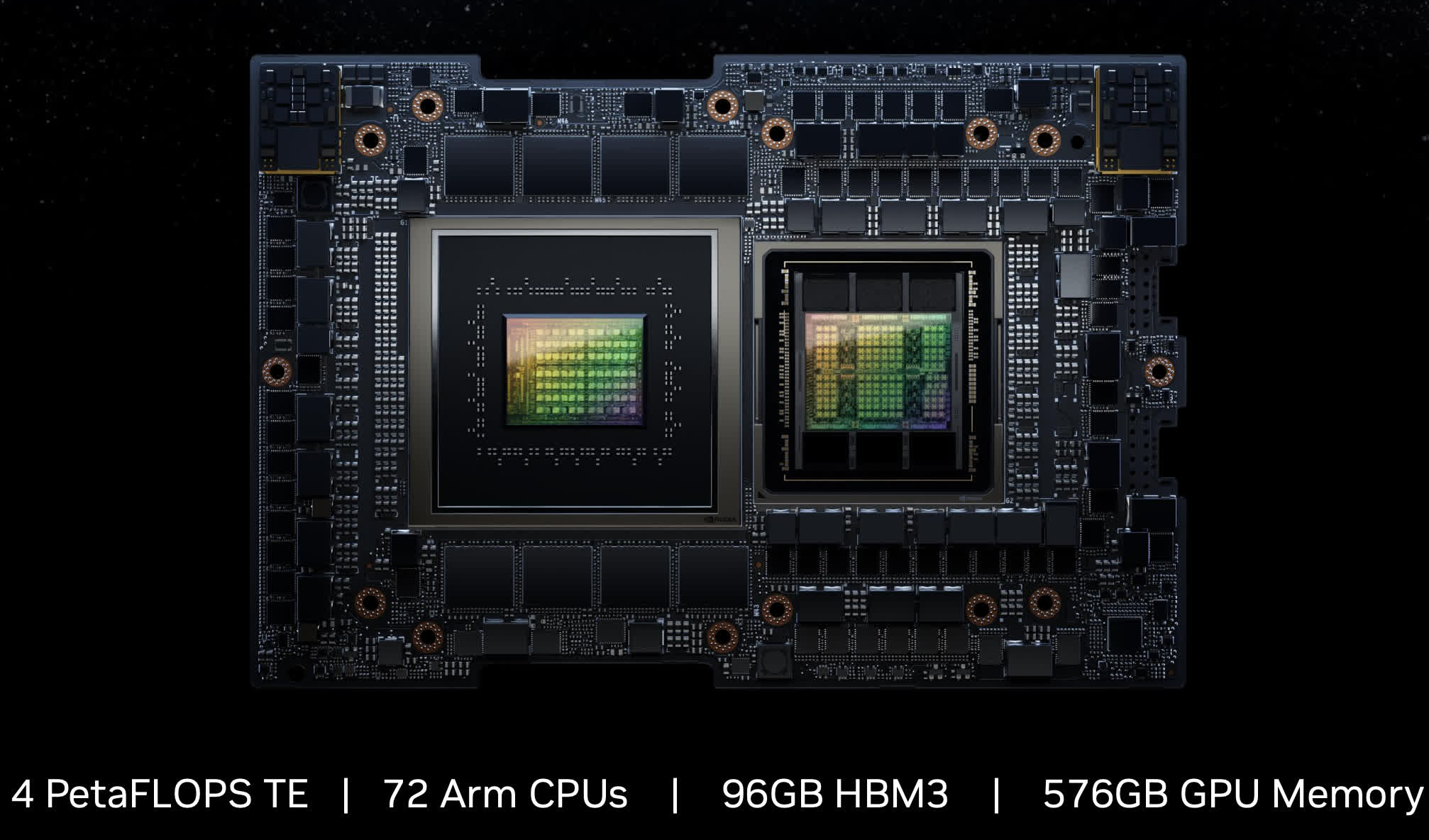

À l’heure actuelle, le monde est obsédé par la position dominante de Nvidia sur le marché, mais il est important d’approfondir cela un peu plus. Nvidia est clairement le leader sur le marché des puces d’entraînement, mais cela ne représente qu’environ 10 à 20 % de la demande de puces IA. Il existe un marché considérablement plus important pour les puces d’inférence, qui interprètent les modèles entraînés et répondent aux requêtes des utilisateurs. Ce segment est beaucoup plus important et aucune entité, pas même Nvidia, n’a de verrou sur ce marché.

De plus, nous devons décomposer le marché. Les utilisateurs auront besoin d’un traitement d’inférence dans les environnements de périphérie et de cloud. L’inférence cloud sera en fonction de la demande du centre de données. Le marché total des semi-conducteurs pour centres de données s’élève aujourd’hui à environ 50 milliards de dollars (sans compter la mémoire, qui est certes une exclusion importante). Ce marché de l’inférence est non seulement important mais également assez fragmenté.

Note de l’éditeur:

Auteur invité Jonathan Goldberg est le fondateur de D2D Advisory, un cabinet de conseil multifonctionnel. Jonathan a développé des stratégies de croissance et des alliances pour des entreprises des secteurs de la téléphonie mobile, des réseaux, des jeux et des logiciels.

Nvidia a sans doute déjà une grande part de cela, probablement la plus grande, étant donné qu’une quantité substantielle de travail d’IA est effectuée sur les GPU. AMD cible également ce marché, mais ils sont loin derrière Nvidia. De plus, il s’agit d’un domaine où les hyperscalers utilisent une grande partie de leurs puces propriétaires – AWS sur Inferentia et Google sur TPU, pour n’en nommer que quelques-uns. Il convient de noter qu’une grande partie de ce travail est encore effectuée sur des processeurs, en particulier avec des GPU haut de gamme en nombre insuffisant. Ce segment du marché devrait rester hautement concurrentiel dans un avenir prévisible. Comme AMD, c’est le marché sur lequel tous les autres fournisseurs de processeurs, de GPU et d’accélérateurs seront en concurrence avec un mélange sain de produits.

Cela nous amène à une autre opportunité importante – l’inférence à la périphérie. Le terme « edge » est souvent utilisé à mauvais escient, mais pour nos besoins ici, nous nous référons principalement à tout appareil entre les mains d’un utilisateur final. Aujourd’hui, cela englobe principalement les téléphones et les PC, mais s’étend à d’autres secteurs comme les caméras, les robots, les systèmes industriels et les voitures. Il est difficile de prévoir la taille de ce marché. Au-delà de l’élargissement du champ d’utilisation, une grande partie du silicium de ces appareils est susceptible d’être regroupée dans un système sur puce (SoC) qui exécute toutes les fonctions de ces appareils.

L’iPhone en est un excellent exemple, consacrant une zone de puce substantielle aux cœurs d’IA dans son processeur de la série A. Selon certaines mesures, le contenu de l’IA occupe déjà 20 % des puces de la série A, ce qui est considérable quand on sait que les 80 % restants doivent exécuter toutes les autres fonctions du téléphone. De nombreuses autres entreprises adoptent également des stratégies SoC AI.

Une question prédominante dans le domaine de l’IA est la quantité de puissance de calcul nécessaire pour exécuter les derniers grands modèles de langage (LLM) comme GPT et Stable Diffusion. Il existe un intérêt considérable à exécuter ces modèles avec l’empreinte informatique la plus légère possible, et la communauté open source a fait des progrès remarquables en une période relativement courte.

Cela implique que le marché de l’Edge Inference restera probablement très fragmenté. Une approche pragmatique consisterait à supposer que pour les catégories existantes, telles que les téléphones et les PC, le silicium IA sera fourni par des sociétés fournissant déjà des puces pour ces appareils, telles que Qualcomm et Intel/AMD.

Comme indiqué précédemment, il est actuellement très difficile d’obtenir des prévisions fiables sur la taille du marché du silicium AI. Cette situation n’est pas aidée par l’ambiguïté entourant l’utilisation pratique des LLM et d’autres modèles pour le travail réel. Ensuite, il y a des questions sur quoi et comment compter. Par exemple, si un hyperscaler achète plusieurs centaines de milliers de processeurs, qui exécuteront des réseaux de neurones ainsi que des charges de travail traditionnelles, ou si quelqu’un ajoute quelques dizaines de millimètres carrés de blocs d’IA à son SoC, comment comptabilisons-nous ceux-ci ? Actuellement, notre estimation approximative suggère que le marché du silicium IA comprendra environ 15 % pour la formation, 45 % pour l’inférence de centre de données et 40 % pour l’inférence de périphérie.

Cela a des implications importantes pour quiconque envisage d’entrer sur ce marché. Dans un avenir prévisible, Nvidia maintiendra son emprise sur le marché de la formation. Le marché de l’inférence des centres de données semble attrayant, mais comprend déjà une myriade d’entreprises, y compris des géants comme Nvidia, AMD et Intel, ainsi que du silicium interne Roll-Your-Own de clients. L’inférence Edge est susceptible d’être dominée par les fournisseurs existants de silicium traditionnel, qui investissent tous massivement dans la prise en charge des transformateurs et des LLM. Alors, quelles opportunités existent pour les nouveaux entrants ? Nous pouvons voir essentiellement quatre options :

- Fournissez IP ou chiplets à l’un des fournisseurs de SoC. Cette approche présente l’avantage d’exiger relativement peu de fonds propres; laissez votre client gérer les paiements à TSMC. Il existe une pléthore de clients visant à construire des SoC. Alors que beaucoup peuvent souhaiter tout gérer en interne, beaucoup sont susceptibles d’opter pour une assistance si nécessaire.

- Constituez-vous un gros (vraiment gros) trésor de guerre et partez à la conquête du marché des centres de données. Il s’agit d’une entreprise difficile pour plusieurs raisons, notamment parce que le nombre de clients est limité, mais les récompenses potentielles sont énormes.

- Trouvez un nouvel appareil périphérique qui pourrait bénéficier d’une solution sur mesure. Déplacez l’attention des téléphones et des ordinateurs portables vers les caméras, les robots, les systèmes industriels, etc. Cette voie n’est pas facile non plus. Certains de ces appareils sont extrêmement bon marché et ne peuvent donc pas accueillir de puces avec des ASP élevés. Il y a quelques années, nous avons observé de nombreux pitchs pour les entreprises cherchant à faire de l’IA basse consommation sur des caméras et des drones. Très peu ont survécu.

- Enfin, il y a l’automobile, le Grand Espoir de toute l’industrie. Ce marché est encore très fragmenté et quelque peu nébuleux. La fenêtre d’entrée n’est pas vaste, mais l’opportunité est substantielle.

Pour résumer, le marché de l’IA est déjà largement parlé. Cela ne signifie pas que tout espoir est perdu pour ceux qui s’y aventurent, mais les entreprises devront être très ciblées et extrêmement judicieuses dans leur choix de marchés et de clients.