Pourquoi est-ce important: Lors du discours d’ouverture du GTC 2023, le PDG de Nvidia, Jensen Huang, a souligné une nouvelle génération de percées qui visent à apporter l’IA à tous les secteurs. En partenariat avec des géants de la technologie comme Google, Microsoft et Oracle, Nvidia fait des progrès dans la formation, le déploiement, les semi-conducteurs, les bibliothèques de logiciels, les systèmes et les services cloud en matière d’IA. Parmi les autres partenariats et développements annoncés, citons Adobe, AT&T et le constructeur automobile BYD.

Huang indiqué de nombreux exemples de l’écosystème de Nvidia en action, notamment les utilisateurs de Microsoft 365 et d’Azure accédant à une plate-forme pour créer des mondes virtuels, et Amazon utilisant des capacités de simulation pour former des robots d’entrepôt autonomes. Il a également mentionné l’essor rapide des services d’IA génératifs comme ChatGPT, qualifiant son succès de “moment iPhone de l’IA”.

Basé sur l’architecture Hopper de Nvidia, Huang a annoncé un nouveau GPU H100 NVL qui fonctionne dans une configuration à double GPU avec NVLink, pour répondre à la demande croissante d’IA et d’inférence LLM. Le GPU dispose d’un Transformer Engine conçu pour traiter des modèles tels que GPT, réduisant ainsi les coûts de traitement LLM. Comparé au HGX A100 pour le traitement GPT-3, un serveur avec quatre paires de H100 NVL peut être jusqu’à 10 fois plus rapide, affirme la société.

Le cloud computing devenant une industrie de 1 billion de dollars, Nvidia a développé le processeur Grace basé sur Arm pour les charges de travail d’IA et de cloud. La société revendique des performances 2x supérieures à celles des processeurs x86 avec la même enveloppe de puissance dans les principales applications de centre de données. Ensuite, la superpuce Grace Hopper combine le processeur Grace et le GPU Hopper, pour traiter des ensembles de données géants que l’on trouve couramment dans les bases de données d’IA et les grands modèles de langage.

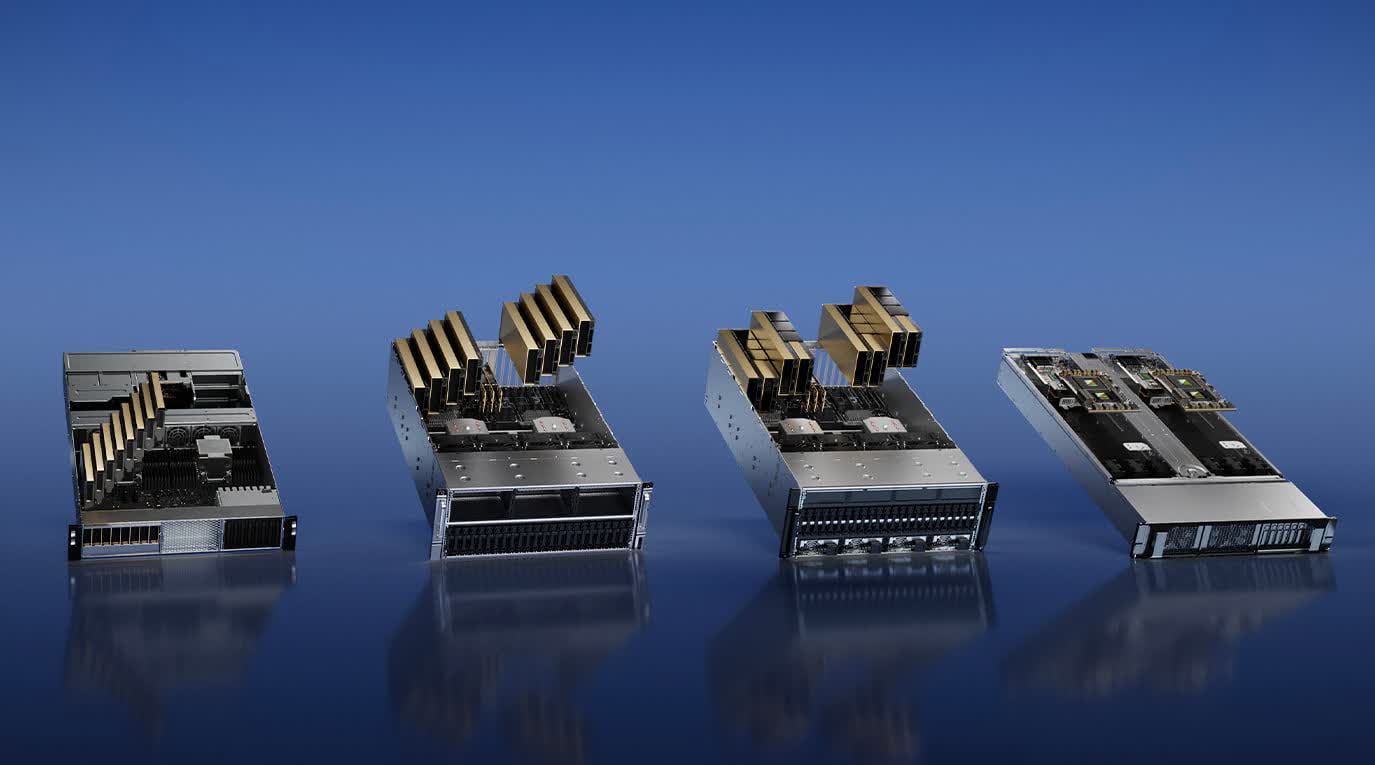

En outre, le PDG de Nvidia affirme que sa plate-forme DGX H100, comprenant huit GPU Nvidia H100, est devenue le modèle pour la construction d’une infrastructure d’IA. Plusieurs grands fournisseurs de cloud, dont Oracle Cloud, AWS et Microsoft Azure, ont annoncé leur intention d’adopter les GPU H100 dans leurs offres. Les fabricants de serveurs comme Dell, Cisco et Lenovo fabriquent également des systèmes alimentés par des GPU Nvidia H100.

Parce que clairement, les modèles d’IA génératifs font fureur, Nvidia propose de nouveaux produits matériels avec des cas d’utilisation spécifiques pour exécuter plus efficacement les plates-formes d’inférence. Le nouveau GPU L4 Tensor Core est un accélérateur universel optimisé pour la vidéo, offrant des performances vidéo alimentées par l’IA 120 fois meilleures et une efficacité énergétique améliorée de 99 % par rapport aux processeurs, tandis que le L40 pour la génération d’images est optimisé pour les graphiques et la 2D activée par l’IA. , vidéo et génération d’images 3D.

A lire aussi : Nvidia a-t-il remporté le marché de la formation à l’IA ?

Omniverse de Nvidia est également présent dans la modernisation de l’industrie automobile. D’ici 2030, l’industrie marquera une transition vers les véhicules électriques, de nouvelles usines et des méga-usines de batteries. Nvidia affirme qu’Omniverse est adopté par de grandes marques automobiles pour diverses tâches : Lotus l’utilise pour l’assemblage de postes de soudage virtuels, Mercedes-Benz pour la planification et l’optimisation de la chaîne de montage et Lucid Motors pour la construction de magasins numériques avec des données de conception précises. BMW collabore avec idealworks pour la formation de robots d’usine et pour planifier une usine de véhicules électriques entièrement dans Omniverse.

Dans l’ensemble, il y avait trop d’annonces et des partenariats à mentionner, mais sans doute la dernière grande étape est venue du côté de la fabrication. Nvidia a annoncé une percée dans vitesse de production de puces et l’efficacité énergétique avec l’introduction de « cuLitho », une bibliothèque logicielle conçue pour accélérer jusqu’à 40 fois la lithographie computationnelle.

Jensen a expliqué que cuLitho peut réduire considérablement les calculs extensifs et le traitement des données nécessaires à la conception et à la fabrication des puces. Cela se traduirait par une consommation d’électricité et de ressources considérablement réduite. TSMC et le fournisseur d’équipements de semi-conducteurs ASML prévoient d’intégrer cuLitho dans leurs processus de production.