Une patate chaude : Bien qu’il existe un nombre croissant de garanties utilisées par les services en ligne qui identifient et signalent les images d’abus d’enfants, ces systèmes ne sont pas infaillibles et peuvent avoir un impact dévastateur sur les accusés à tort. C’est le cas d’un père dont le compte Google est toujours fermé après que l’entreprise ait signalé par erreur des images médicales de l’aine de son tout-petit comme de la pornographie juvénile.

Selon un Reportage du New York Times, le père, Mark, a pris les photos en février de l’année dernière sur les conseils d’une infirmière avant un rendez-vous vidéo avec un médecin. L’épouse de Mark a utilisé le téléphone Android de son mari pour prendre des photos de la région génitale enflée du garçon et les a envoyées par SMS à son iPhone afin qu’elles puissent être téléchargées sur le système de messagerie du fournisseur de soins de santé. Le médecin a prescrit des antibiotiques, mais ce n’était pas la fin.

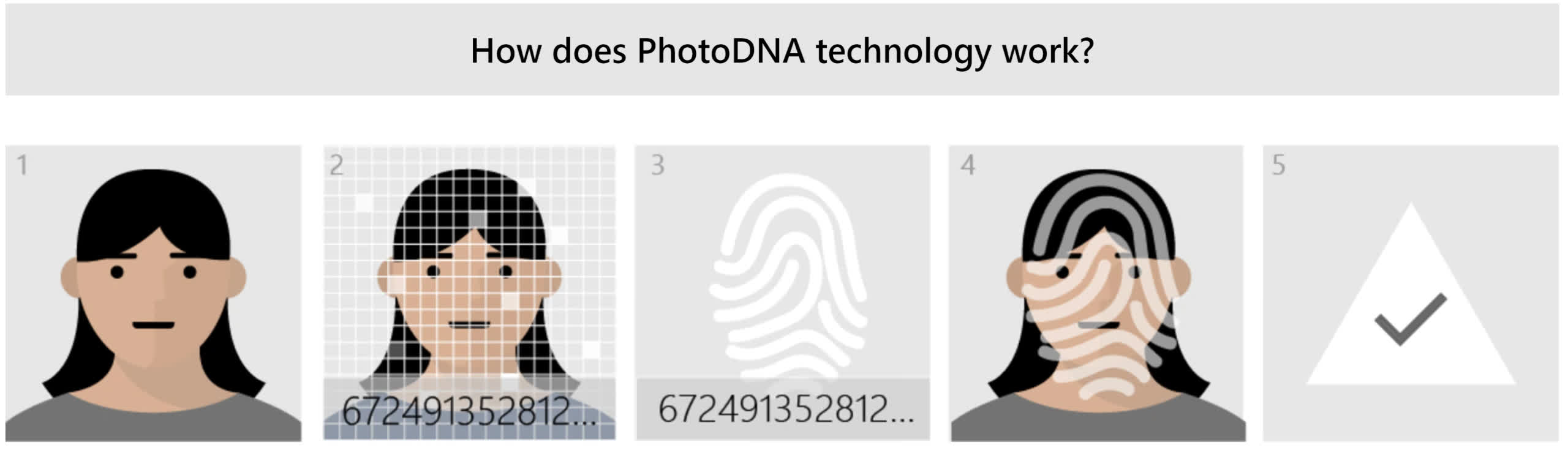

Il semble que les images aient été automatiquement sauvegardées sur Google Photos, à quel point l’entreprise outil d’intelligence artificielle et de Microsoft PhotoADN les a signalés comme matériel d’abus sexuel d’enfants (CSAM). Mark a reçu une notification deux jours plus tard l’informant que ses comptes Google, y compris Gmail et le service téléphonique Google Fi, avaient été verrouillés en raison d’un “contenu préjudiciable” qui constituait “une grave violation des politiques de Google et pourrait être illégal”.

En tant qu’ancien ingénieur logiciel qui avait travaillé sur des outils d’IA similaires pour identifier le contenu problématique, Mark supposait que tout serait éclairci une fois qu’un modérateur de contenu humain aurait examiné les photos.

Mais Mark a fait l’objet d’une enquête du département de police de San Francisco sur des “vidéos d’exploitation d’enfants” en décembre. Il a été innocenté de tout crime, mais Google n’a toujours pas rétabli ses comptes et affirme qu’il s’en tient à sa décision.

“Nous suivons la loi américaine pour définir ce qui constitue le CSAM et utilisons une combinaison de technologie de correspondance de hachage et d’intelligence artificielle pour l’identifier et le supprimer de nos plateformes”, a déclaré Christa Muldoon, porte-parole de Google.

Claire Lilley, responsable des opérations de sécurité des enfants chez Google, a déclaré que les examinateurs n’avaient pas détecté d’éruption cutanée ou de rougeur sur les photos de Mark. Le personnel de Google qui examine le CSAM est formé par des pédiatres pour rechercher des problèmes tels que des éruptions cutanées, mais les experts médicaux ne sont pas consultés dans ces cas.

Lilley a ajouté qu’un examen plus approfondi du compte de Mark avait révélé une vidéo de six mois plus tôt montrant un enfant couché dans son lit avec une femme dévêtue. Mark dit qu’il ne se souvient pas de la vidéo et qu’il n’y a toujours pas accès.

“Je peux l’imaginer. Nous nous sommes réveillés un matin. C’était une belle journée avec ma femme et mon fils, et je voulais enregistrer ce moment”, a déclaré Mark. “Si seulement nous dormions en pyjama, tout cela aurait pu être évité.”

Nous gagnons.

Apple a annoncé des retards dans ses outils d’analyse de téléphone prévus pendant qu’il effectue davantage de recherches. Mais l’entreprise doit aller plus loin et abandonner entièrement son projet de mettre une porte dérobée dans son cryptage. https://t.co/d0N1XDnRl3

— EFF (@EFF) 3 septembre 2021

L’incident met en évidence les problèmes associés aux systèmes automatisés de détection d’images d’abus sexuels sur des enfants. Les projets d’Apple de rechercher le CSAM sur ses appareils avant que les photos ne soient téléchargées sur le cloud ont suscité un tollé de la part des défenseurs de la vie privée l’année dernière. Il a finalement mis la fonctionnalité en attente indéfinie. Cependant, une fonctionnalité facultative similaire est disponible pour les comptes enfants sur le plan de partage familial.

Titre : Kai Wenzel