Dans le contexte: Étant donné à quel point l’IA générative a été un sujet brûlant, en particulier pour les fournisseurs de cloud computing comme Microsoft et Google, il a été un peu surprenant de ne pas en entendre davantage sur le sujet d’Amazon. Après tout, leur plate-forme de cloud computing AWS détient la première position de part de marché selon plusieurs entreprises qui suivent ces chiffres.

Il s’avère qu’Amazon et AWS ont créé plusieurs IA génératives annonces à la mi-avril, mais ils n’ont pas généré autant de buzz ou d’intérêt initial qu’on aurait pu s’y attendre. Ayant eu la chance de digérer les nouvelles et d’observer où une grande partie de l’attention sur les nouvelles et les histoires liées à l’IA générative a été concentrée ces derniers temps, je peux maintenant comprendre pourquoi cela a pu être le cas.

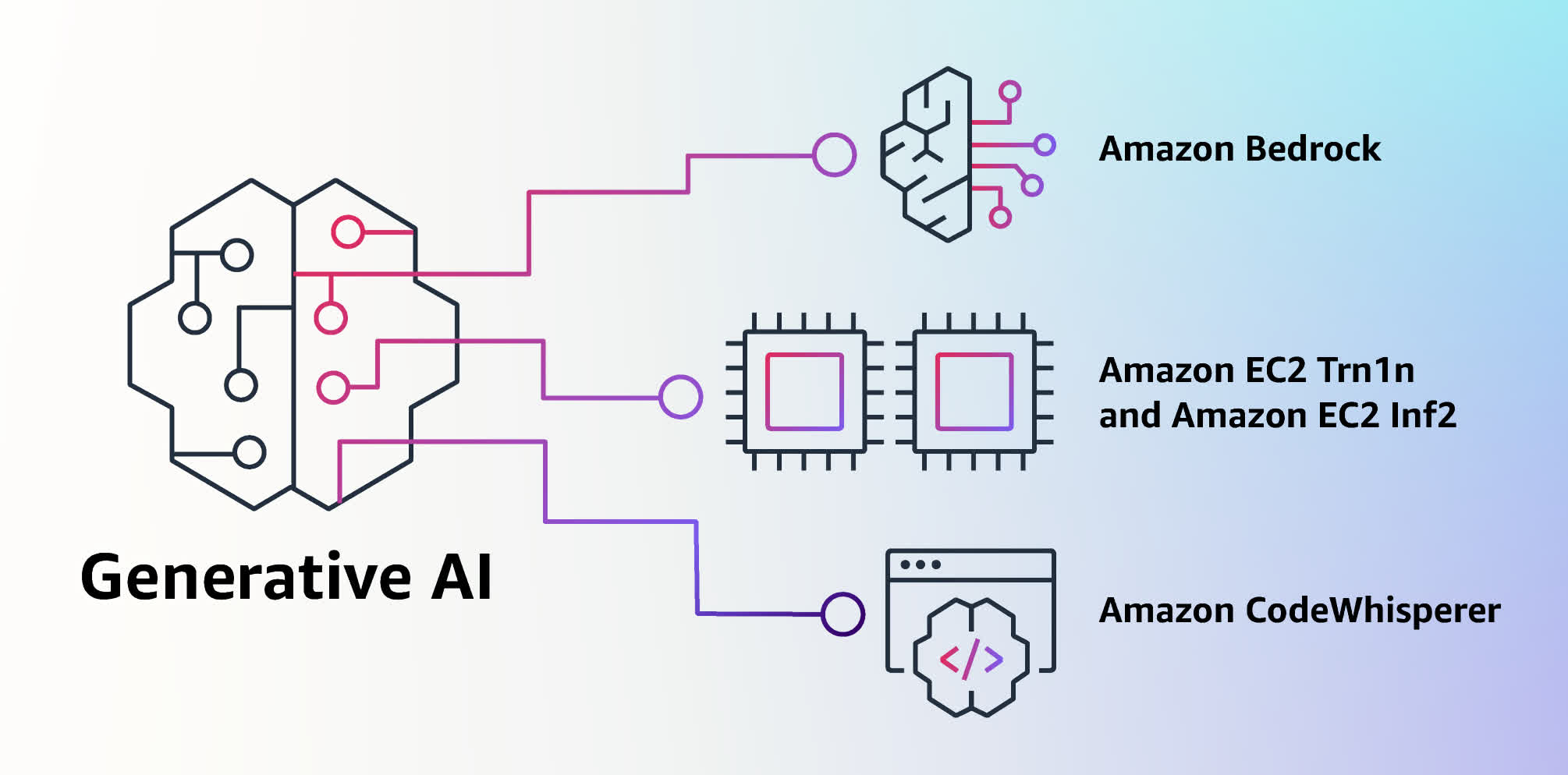

En bref, l’histoire d’Amazon autour de l’IA est tout simplement plus complexe que la plupart. Au lieu d’avoir une seule application ou un petit ensemble d’applications basées sur de grands modèles de langage (LLM), comme ChatGPT ou Stable Diffusion, Amazon a lancé un service AWS appelé Substrat rocheux qui est conçu pour permettre aux entreprises de créer des applications en utilisant l’un des différents modèles de base d’IA.

Certains d’entre eux sont en fait des LLM créés par Amazon – appelés Titan – mais ils ne sont pas encore disponibles pour un usage général. Amazon a également annoncé la disponibilité générale d’un outil de développement appelé CodeWhispererprésenté pour la première fois l’année dernière, qui, selon eux, est basé sur un modèle de base d’IA générative.

CodeWhisperer peut générer automatiquement du code à partir d’une entrée en langage naturel dans l’un des 15 langages de programmation différents, offrant la comparaison conceptuelle la plus proche avec des outils similaires de Microsoft et Google (entre autres). Cependant, il n’est disponible que pour les développeurs (bien qu’il soit gratuit pour les développeurs individuels).

Malgré ces annonces moins favorables à l’actualité d’Amazon, les idées derrière Bedrock sont intrigantes. Ils suggèrent une approche évolutive de la manière dont les entreprises ont l’intention d’offrir et de consommer des produits et services génératifs axés sur l’IA. Tout d’abord, Amazon a mis l’accent sur le choix en ce qui concerne les modèles mis à disposition dans le cadre du service. Ils prévoient initialement d’offrir l’accès à la famille Jurassic-2 de LLM multilingues d’AI21 Labs (pour la génération de texte, le résumé, etc.), le LLM Claude conversationnel et axé sur le traitement de texte d’Anthropic et l’outil d’IA générant des images Stable Diffusion de Stability AI, ainsi que leurs propres modèles d’intégration Titan LLM et Titan.

Le modèle des incorporations est remarquable car au lieu de générer du texte, il est conçu pour générer des représentations numériques (appelées incorporations) qui, selon Amazon, « contiennent la signification sémantique du texte ». Amazon a en outre expliqué qu’il utilisait une version de son modèle d’incorporation pour aider à alimenter le moteur de recherche de produits sur Amazon.com afin que les gens puissent trouver ce qu’ils recherchent sans nécessairement avoir à taper le mot ou la phrase correcte. Bedrock rend tous ces modèles accessibles aux développeurs via des API ouvertes.

Bedrock démontre un intérêt croissant à avoir plus d’options pour les modèles fondamentaux de base qui alimentent les services d’IA générative. Alors que la plupart de ces énormes modèles sont connus pour être des outils à usage général – en effet, c’est l’une des principales différences que les architectures de réseau neuronal basées sur des transformateurs ont permises par rapport aux modèles d’apprentissage automatique plus spécialisés précédents – il y a toujours un sentiment que différents modèles pourraient être mieux adapté aux différentes tâches.

Il reste à voir si le marché exige vraiment ce degré de choix ou si les organisations sont satisfaites de la simplicité d’utilisation d’un modèle unique à usage général pour plusieurs applications. Le bon sens (et la dynamique du marché) suggèrent que des choix accrus sont inévitables, mais il est également très facile d’imaginer que les options explosent de manière incontrôlable. Bien sûr, une gamme de choix peut être moins importante que d’offrir l’accès au bon choix, et le manque initial de support de Bedrock pour l’immensément populaire ChatGPT pourrait être un problème.

Une capacité encore plus intrigante de Bedrock est la possibilité de personnaliser le modèle que vous choisissez d’utiliser pour une application donnée avec les propres données d’une organisation. De nombreuses organisations trouveront cela attrayant pour plusieurs raisons. Premièrement, aussi impressionnants que puissent être les outils d’IA générative à usage général, les organisations dépensent régulièrement des millions de dollars pour créer des applications personnalisées qui répondent à leurs besoins spécifiques, et elles voudront le même niveau de personnalisation pour leurs outils d’IA générative. Être capable de former un modèle en utilisant les propres documents d’une entreprise et d’autres informations devrait également permettre la génération d’une sortie qui correspond plus étroitement aux exigences spécifiques de l’organisation.

Deuxièmement, la manière dont AWS effectue cette personnalisation consiste à créer une copie du modèle principal, puis à former ce modèle privé dans un cloud privé virtuel au sein d’AWS. Troisièmement, en raison de la façon dont cela fonctionne, cela signifie que les requêtes ou autres entrées dans le modèle sont également gardées privées (et cryptées) et ne sont pas utilisées pour une formation ultérieure du modèle principal à usage général. Alors que les entreprises commencent à en apprendre davantage sur ces risques avec des modèles à usage général, je suis convaincu que ces capacités passeront des fonctionnalités avancées aux exigences de base, mais pour l’instant, c’est un bel avantage pour AWS.

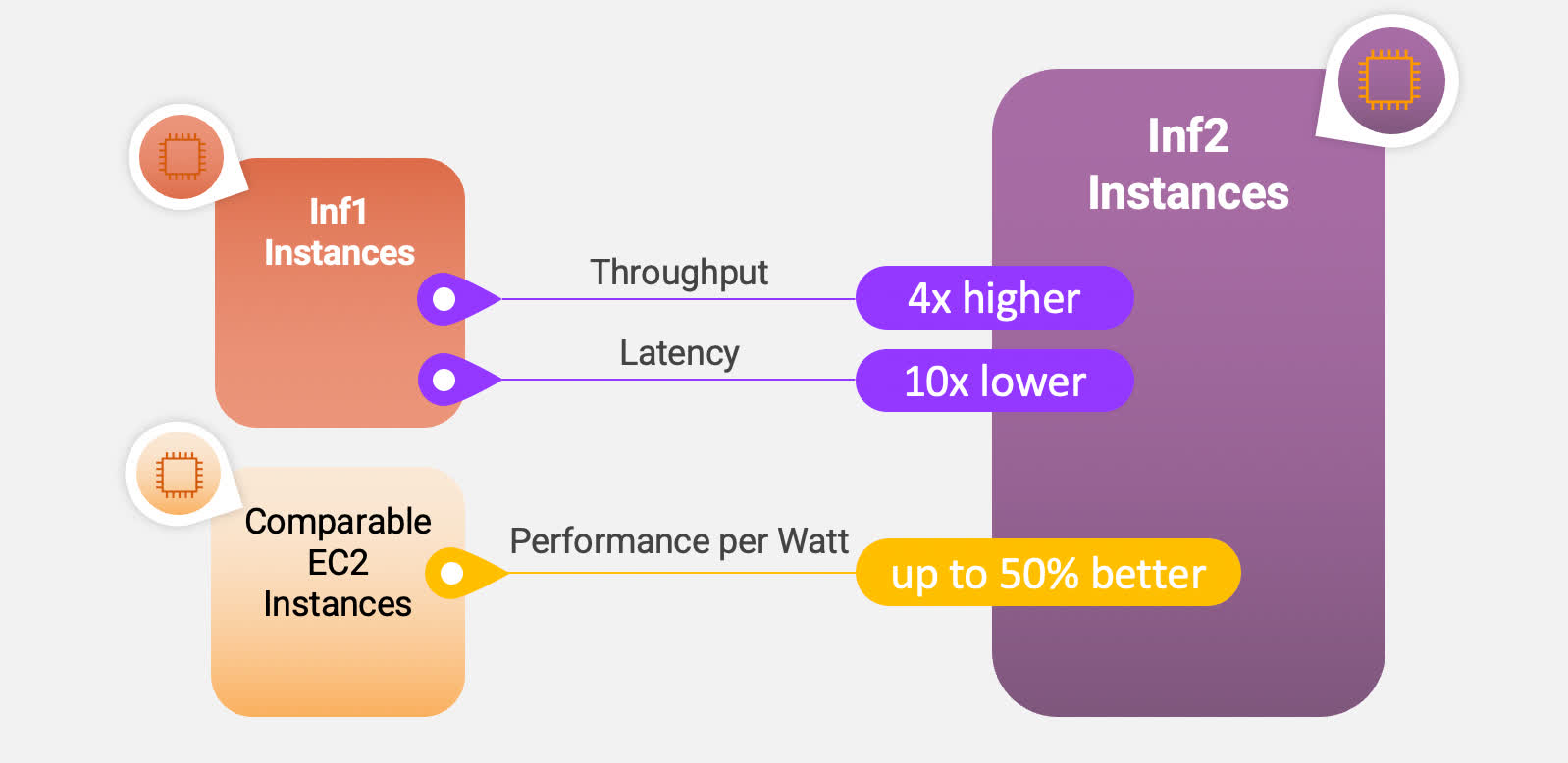

Améliorations des performances clés avec les nouvelles instances Inf2

D’un point de vue matériel, AWS a également annoncé de nouvelles instances de calcul (Inf2 et Trn1n) spécialement conçues pour exécuter à la fois la formation de modèles d’IA et les charges de travail d’inférence alimentées par le propre silicium de l’entreprise : les puces Inferentia2 récemment mises à niveau pour l’inférence et les puces Trainium pour la formation.

Bien qu’il soit évidemment formidable pour Amazon de présenter son propre silicium personnalisé, ce qui est important à propos de ces puces, c’est qu’elles se concentrent sur l’exécution de ces tâches difficiles à des niveaux de puissance inférieurs. Comme de nombreuses entreprises (et fournisseurs de cloud) le découvrent rapidement, la formation et l’exécution de ces modèles nécessitent une énorme quantité de calculs et, par conséquent, d’énergie électrique, ce qui se traduit directement par des coûts plus élevés. Je m’attends à voir des avancées significatives dans ce domaine de la part de tous les principaux acteurs des semi-conducteurs au cours des prochaines années, mais il est bon de voir AWS prendre des mesures importantes dans cette direction.

Le dernier point à souligner est que la stratégie d’IA générative d’Amazon est clairement axée sur les développeurs, et non sur les utilisateurs professionnels ni les consommateurs, ce qui rend l’annonce plus difficile à expliquer et plus difficile à apprécier. D’un point de vue commercial, cependant, il est logique et positionne bien l’entreprise de continuer à servir de plate-forme où les entreprises vont créer des applications, stocker leurs données et exploiter ces données pour de nouvelles informations.

En fin de compte, l’histoire n’est pas aussi flashy que certains des développements que nous avons commencé à voir d’autres grands acteurs de la technologie qui concernent directement les consommateurs, mais il est clair qu’Amazon a l’intention d’être un acteur sérieux dans le paysage en plein essor des plateformes d’IA génératives, outils et services pour les entreprises.

Bob O’Donnell est le fondateur et analyste en chef de TECHnalysis Research, LLC une société de conseil en technologie qui fournit des services de conseil stratégique et d’étude de marché à l’industrie technologique et à la communauté financière professionnelle. Vous pouvez le suivre sur Twitter @bobodtech