Prospective : Un nouveau rapport a révélé l’énorme quantité de GPU Nvidia utilisés par Microsoft et les innovations qu’il a fallu pour les organiser pour aider OpenAI à former ChatGPT. La nouvelle survient alors que Microsoft annonce une mise à niveau importante de son supercalculateur d’IA pour poursuivre son initiative d’IA générative.

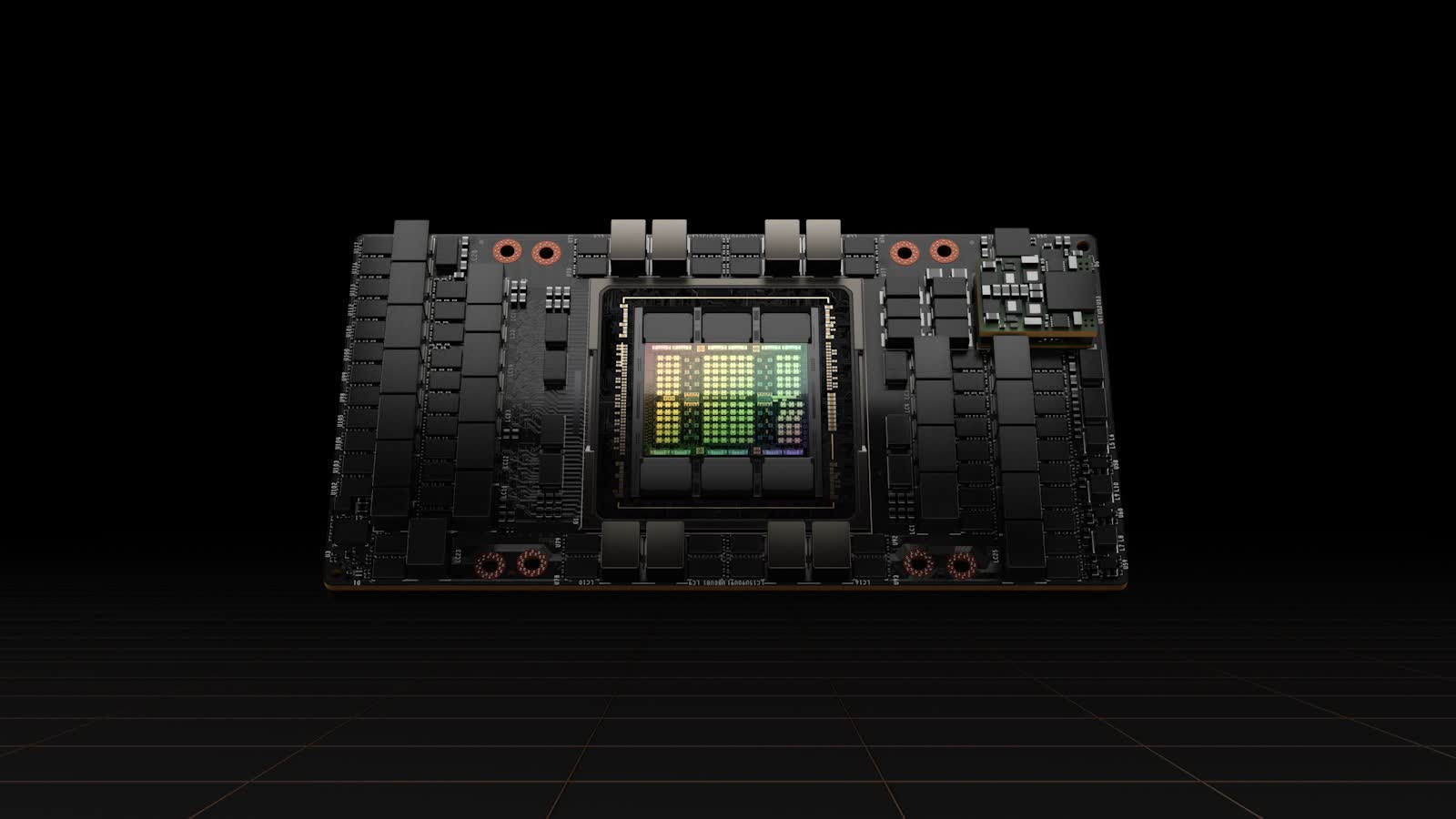

Selon Bloomberg, OpenAI qualifié ChatGPT sur un superordinateur Microsoft construit à partir de dizaines de milliers de GPU Nvidia A100. Microsoft a annoncé une nouvelle baie utilisant Les nouveaux GPU H100 de Nvidia cette semaine.

Le défi auquel les entreprises sont confrontées a commencé en 2019 après que Microsoft a investi 1 milliard de dollars dans OpenAI tout en acceptant de construire un supercalculateur d’IA pour la startup. Cependant, Microsoft n’avait pas le matériel en interne pour ce dont OpenAI avait besoin.

Après avoir acquis les puces de Nvidia, Microsoft a dû repenser la manière dont il organisait un nombre aussi important de GPU pour éviter les surchauffes et les pannes de courant. La société ne dira pas précisément combien l’effort a coûté, mais le vice-président exécutif Scott Guthrie a mis le chiffre au-dessus de plusieurs centaines de millions de dollars.

Lisez aussi : Nvidia a-t-il remporté le marché de la formation à l’IA ?

L’exécution simultanée de tous les A100 a forcé Redmond à réfléchir à la façon dont il les plaçait, ainsi que leurs alimentations. Il a également dû développer de nouveaux logiciels pour augmenter l’efficacité, s’assurer que l’équipement réseau pouvait supporter d’énormes quantités de données, concevoir de nouveaux chemins de câbles qu’il pouvait fabriquer indépendamment et utiliser plusieurs méthodes de refroidissement. Selon le changement climatique, les techniques de refroidissement comprenaient l’évaporation, les refroidisseurs de marais et l’air extérieur.

Depuis le succès initial de ChatGPT, Microsoft et certains de ses concurrents ont commencé à travailler sur des modèles d’IA parallèles pour les moteurs de recherche et d’autres applications. Pour accélérer son IA générative, la société a introduit la machine virtuelle ND H100 v5, une machine virtuelle qui peut utiliser entre huit et des milliers de GPU Nvidia H100.

Les H100 se connectent via NVSwitch et NVLink 4.0 avec 3,6 To/s de bande passante bisectionnelle entre chacun des 8 GPU locaux au sein de chaque machine virtuelle. Chaque GPU dispose de 400 Go/s de bande passante via les connexions Nvidia Quantum-2 CX7 InfiniBand et PCIe5 de 64 Go/s. Chaque machine virtuelle gère 3,2 To/s via un réseau fat-tree non bloquant. Le nouveau système de Microsoft comprend également des processeurs Intel Xeon de 4e génération et une RAM DDR5 à 16 canaux à 4800 MHz.

Microsoft prévoit d’utiliser la machine virtuelle ND H100 v5 pour son nouveau moteur de recherche Bing alimenté par l’IA, son navigateur Web Edge et Microsoft Dynamics 365. La machine virtuelle est désormais disponible en préversion et sera livrée en standard avec le portefeuille Azure. Utilisateurs potentiels peut demander l’accès.